全面掌握robots.txt编写技巧:详解robots.txt写法大全

网站robots.txt怎么写?robots.txt写法大全解析

在构建和维护网站时,robots.txt文件是一个不可或缺的组成部分。这个文件是网站与搜索引擎爬虫之间的桥梁,通过简单的文本格式规定了哪些内容可以被搜索引擎抓取,哪些内容则不应被索引。正确编写robots.txt文件不仅可以保护网站的隐私内容,还能提高搜索引擎的效率,避免重复抓取和浪费服务器资源。下面,我们就来详细探讨robots.txt文件的写法及其实际应用。

robots.txt基础知识

robots.txt是一个存放在网站根目录下的纯文本文件,其后缀必须为.txt,且文件名必须全部小写。该文件遵循robots协议(也称爬虫协议、机器人协议等),全称是网络爬虫扫除规范(Robots Exclusion Protocol)。其主要作用是告诉搜索引擎爬虫哪些页面可以抓取,哪些页面不能抓取,确保网站的隐私内容不会被索引。

创建robots.txt文件的步骤

1. 新建文本文档:在电脑或笔记本上,右击桌面选择“新建文本文档”。

2. 重命名文件:将新建的文本文档重命名为robots.txt,注意文件名必须全部小写。

3. 编写规则:根据网站的需求,编写相应的robots.txt规则。

4. 上传文件:使用FTP工具将robots.txt文件上传到网站的根目录下。

robots.txt文件的基本语法

robots.txt文件的语法相对简单,主要包含以下几个关键部分:

User-agent:用于定义搜索引擎爬虫的名称。可以使用通配符“*”表示所有爬虫,也可以指定特定爬虫的名称,如Baiduspider(百度爬虫)、Googlebot(谷歌爬虫)等。

Disallow:用于定义禁止搜索引擎抓取的URL路径。如果Disallow后面没有跟路径,或者路径为空,则表示允许抓取所有页面。

Allow:用于定义允许搜索引擎抓取的URL路径。需要注意的是,并非所有搜索引擎都支持Allow指令,因此在使用时需进行兼容性测试。

robots.txt文件的书写注意事项

1. 文件后缀:robots文件的后缀必须是.txt。

2. 文件位置:robots文件应该存放在网站的根目录,且所有字母都必须小写。

3. 指令大小写:在写robots文件时,User-agent、Disallow、Allow、Sitemap等指令的开头第一个字母必须大写,后面的字母小写。

4. 冒号空格:在冒号(:)后面必须有一个英文状态下的空格。

robots.txt文件的实际应用

1. 允许所有搜索引擎访问

```

User-agent:

Allow: /

```

或者

```

User-agent:

Disallow:

```

这两种写法都表示允许所有搜索引擎爬虫访问网站的所有页面。

2. 禁止所有搜索引擎访问

```

User-agent:

Disallow: /

```

这表示禁止所有搜索引擎爬虫访问网站的任何部分。

3. 禁止特定搜索引擎访问

```

User-agent: Baiduspider

Disallow: /

```

这表示禁止百度爬虫访问网站的所有页面,而允许其他搜索引擎爬虫访问。

4. 允许特定搜索引擎访问

```

User-agent: Baiduspider

Disallow:

```

或者

```

User-agent:

Disallow: /

User-agent: Baiduspider

Allow: /

```

这两种写法都表示仅允许百度爬虫访问网站的所有页面,而禁止其他搜索引擎爬虫访问。

5. 禁止访问特定目录

```

User-agent:

Disallow: /cgi-bin/

Disallow: /tmp/

Disallow: /~joe/

```

这表示禁止搜索引擎爬虫访问/cgi-bin/、/tmp/和/~joe/这三个目录及其子目录中的所有文件。

6. 允许访问特定目录中的部分URL

```

User-agent:

Allow: /cgi-bin/see

Allow: /tmp/hi

Allow: /~joe/look

Disallow: /cgi-bin/

Disallow: /tmp/

Disallow: /~joe/

```

这表示虽然禁止了/cgi-bin/、/tmp/和/~joe/这三个目录的抓取,但允许抓取其中的/cgi-bin/see、/tmp/hi和/~joe/look这三个URL。

7. 禁止访问特定类型的文件

```

User-agent:

Disallow: /*.css$

Disallow: /*.js$

Disallow: /*.php$

```

这表示禁止搜索引擎爬虫访问网站中所有以.css、.js和.php为后缀的文件。

8. 禁止访问动态页面

```

User-agent:

Disallow: /*?

```

这表示禁止搜索引擎爬虫访问网站中所有的动态页面。

9. 只允许访问网站首页

```

User-agent:

Disallow: /

Allow: /

```

这表示只允许搜索引擎爬虫访问网站的首页,而禁止访问其他所有页面。

10. 限制访问特定后缀的URL

```

User-agent:

Disallow: /cgi-bin/*.htm

```

这表示禁止搜索引擎爬虫访问/cgi-bin/目录下所有以.htm为后缀的URL(包括子目录)。

11. 仅允许访问特定后缀的URL

```

User-agent:

Allow: .htm$

Disallow: /

```

这表示仅允许搜索引擎爬虫访问以.htm为后缀的URL,而禁止访问其他所有页面。

总结

robots.txt文件是网站优化和搜索引擎营销中不可或缺的一部分。通过合理编写robots.txt文件,不仅可以保护网站的隐私内容,还能提高搜索引擎的效率,避免不必要的抓取和索引。在编写robots.txt文件时,需要特别注意语法规则和书写格式,确保文件能够正确解析和执行。同时,也需要根据网站的实际需求和搜索引擎的兼容性进行测试和调整,以达到最佳效果。

通过以上对robots.txt文件写法的详细解析,相信读者已经对如何编写robots.txt文件有了更深入的了解。希望这篇文章能够帮助读者更好地掌握robots.txt文件的编写技巧,提高网站的安全性和搜索引擎优化效果。

-

掌握撰写百度百科的技巧与步骤资讯攻略11-24

-

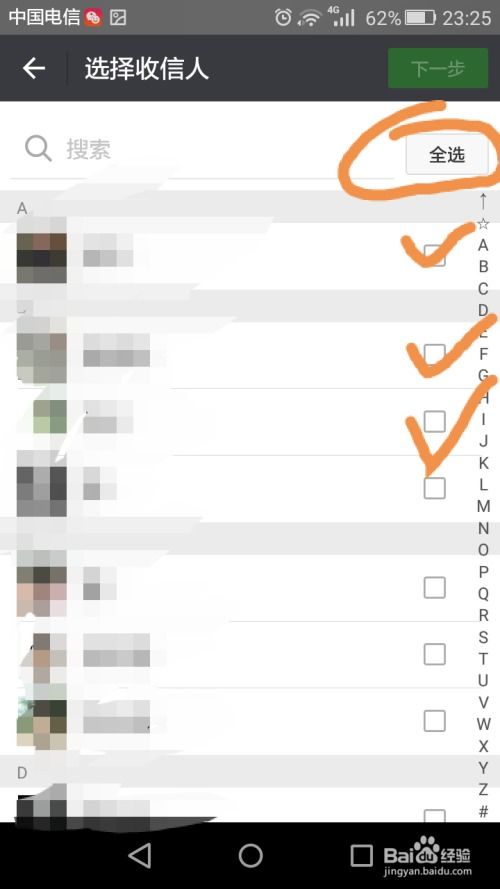

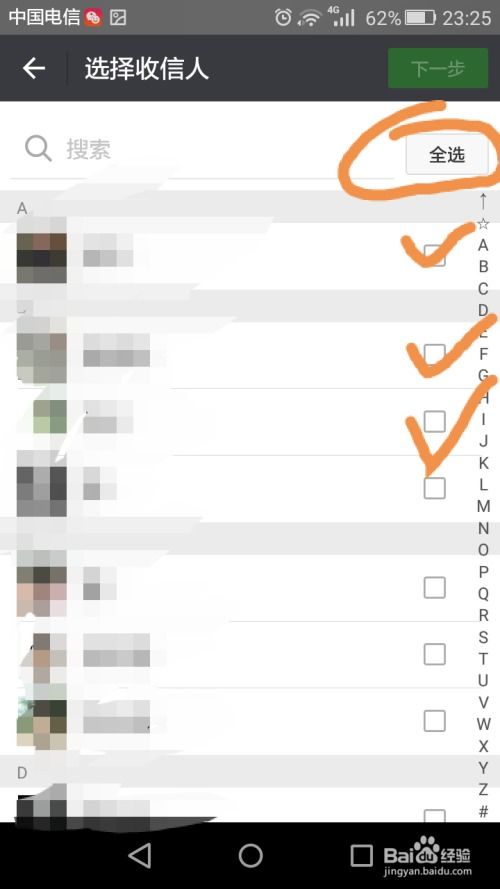

高效掌握:群发短信的正确方法资讯攻略12-09

高效掌握:群发短信的正确方法资讯攻略12-09 -

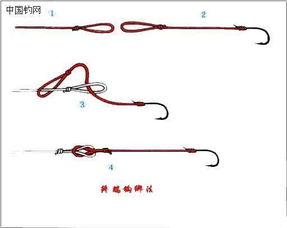

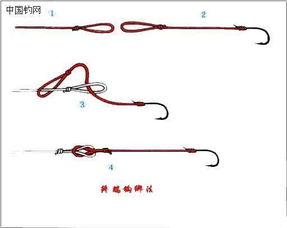

轻松学会!绑鱼钩步骤图解大全资讯攻略11-11

轻松学会!绑鱼钩步骤图解大全资讯攻略11-11 -

初学美甲教程大全有哪些?资讯攻略11-30

初学美甲教程大全有哪些?资讯攻略11-30 -

解锁数字魅力:1到10的标准书写秘籍资讯攻略11-30

解锁数字魅力:1到10的标准书写秘籍资讯攻略11-30 -

揭秘:郝字篆书写法全解析资讯攻略03-29

揭秘:郝字篆书写法全解析资讯攻略03-29