如何快速注册MSN.com账户

在当今信息爆炸的时代,如何从海量的网络资源中高效获取所需内容成为了许多人关注的焦点。特别是对于那些希望了解“注册msn.com的方法”的用户来说,掌握一种有效的数据抓取技巧无疑能够大大提升他们的信息检索效率。本文将详细介绍如何利用在线工具和编程方法抓取关于“注册msn.com的方法”的相关文章数据,为有此需求的读者提供一份实用的指南。

MSN,作为微软旗下的电子邮件及即时通讯服务品牌,在全球范围内拥有大量的用户。随着其服务的不断优化和升级,越来越多的人希望注册MSN账户,以便享受更加便捷和安全的通讯体验。然而,对于初次接触MSN的用户来说,注册过程可能会显得有些陌生和复杂。幸运的是,互联网上存在着大量的文章和教程,详细介绍了注册MSN账户的步骤和注意事项。接下来,我们就来探讨如何抓取这些宝贵的文章数据。

首先,明确我们的目标网站是至关重要的。由于MSN官方网站本身并不直接提供注册教程的文章,我们需要将搜索范围扩大到各大博客、论坛、问答社区等。这些平台上的用户往往根据自己的实践经验撰写了详细的注册教程,对于我们来说具有很高的参考价值。在选择目标网站时,需要注意不同网站的反爬虫机制。一些网站为了防止恶意抓取,可能会设置验证码、IP封禁等措施。因此,在抓取之前,最好先了解目标网站的反爬虫策略,并选择合适的抓取频率和方式,以避免造成不必要的麻烦。

接下来,选择合适的工具进行抓取是关键。对于编程基础较好的用户来说,Python无疑是一个强大的选择。Python拥有丰富的网络爬虫库,如Requests、Beautiful Soup、Scrapy等,这些库能够轻松处理HTTP请求、解析网页内容、提取所需数据等任务。例如,使用Requests库发送HTTP请求,Beautiful Soup库解析HTML文档,提取出包含注册MSN步骤的文本和图片信息。Scrapy则是一个更高级的框架,它提供了完整的爬虫生态系统,包括数据抓取、清洗、存储和分析等功能。

对于编程基础较弱的用户来说,也有一些简单易用的在线工具和浏览器插件可供选择。例如,Octoparse、Parsehub等工具提供了可视化的操作界面,用户只需通过简单的拖拽和设置即可完成数据抓取任务。谷歌浏览器的Web Scraper、Data Miner等插件同样能够帮助用户轻松抓取网页数据。这些工具通常内置了常见的网页解析算法和数据提取规则,用户只需根据自己的需求进行简单的配置即可。

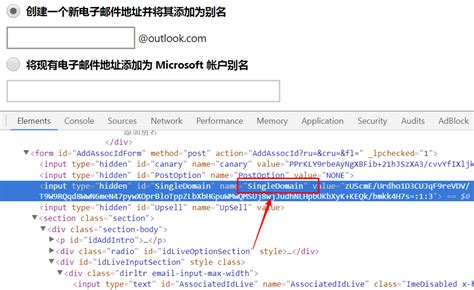

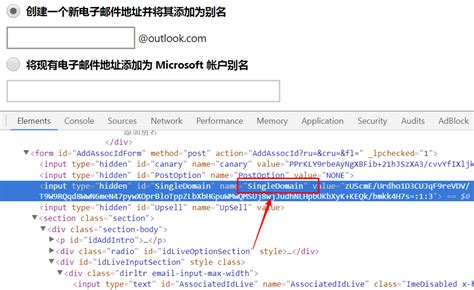

在选择合适的抓取工具后,我们需要对目标网站的结构进行分析。这包括网站的页面布局、URL规律、数据存储方式等。通过浏览器开发者工具(如Chrome的DevTools)可以查看网页的HTML源代码、CSS样式、JavaScript脚本等信息,从而了解网页的结构和元素之间的关系。这些信息将为我们编写抓取代码或配置抓取工具提供重要参考。

在确定了目标网站、选择了合适的工具和抓取方式后,我们可以开始编写代码或配置工具进行数据抓取。以下是一个简单的Python爬虫示例,用于抓取某个博客网站上关于“注册MSN的方法”的文章数据:

```python

import requests

from bs4 import BeautifulSoup

目标URL(示例)

url = 'http://example.com/msn-registration-guide'

发送HTTP请求

response = requests.get(url)

解析HTML文档

soup = BeautifulSoup(response.text, 'html.parser')

提取文章标题

title = soup.find('h1').get_text()

提取文章内容

content = soup.find('div', {'class': 'article-content'}).get_text()

打印提取的数据

print('Title:', title)

print('Content:', content)

```

在实际应用中,我们需要根据目标网站的实际情况调整代码中的选择器(如`find`方法的参数)以准确提取所需数据。此外,还需要处理一些特殊情况,如分页加载、动态加载等。

在抓取到数据后,我们需要将其存储起来以便后续使用。常见的存储方式包括数据库(如MySQL、MongoDB)、文件(如CSV、Excel)等。选择哪种存储方式取决于数据的规模、查询频率以及后续分析的需求。例如,对于大量的结构化数据,数据库存储通常更为高效和灵活;而对于少量的非结构化数据,文件存储则更为简单和直接。

抓取到的数据可能包含一些噪声和不规则性,如多余的HTML标签、空格、换行符等。为了提高数据的质量和可用性,我们需要进行数据清洗和处理。这包括去除无关字符、合并相似字段、转换数据类型等操作。例如,可以使用正则表达式匹配和替换不需要的字符;使用字符串处理函数去除空格和换行符;使用数据类型转换函数将字符串转换为整数或浮点数等。

最后,我们可以对抓取到的数据进行分析和可视化。这有助于我们更好地理解数据的特征和规律,从而发现有价值的信息。常见的分析工具包括Excel、Python的Pandas库、Tableau等。例如,可以使用Pandas库对数据进行统计分析、分组聚合等操作;使用Tableau等可视化工具将数据以图表的形式呈现出来,以便更直观地观察数据的分布和趋势。

需要强调的是,在进行数据抓取的过程中,我们必须遵守法律法规和道德准则。未经允许擅自抓取他人的数据是违法的行为,可能会侵犯他人的隐私权和著作权。因此,在抓取数据之前,最好先了解目标网站的使用协议和数据保护政策,确保自己的行为符合相关法律法规的要求。

此外,为了避免对目标网站造成过大的负担或干扰,我们需要合理设置抓取频率和请求间隔。一些网站可能会根据用户的请求频率和行为模式来判断是否为恶意爬虫,并采取相应的限制措施。因此,在抓取数据时,我们需要保持合理的请求频率和间隔,以避免被目标网站封禁或限制访问。

总之,通过合理的工具选择、网站结构分析、数据抓取与存储、数据清洗与处理以及数据分析和可视化等步骤,我们可以高效地抓取关于“注册MSN的方法”的文章数据,并从中提取出有价值的信息。这不仅能够满足我们个人的信息检索需求,还能够为我们提供宝贵的实践经验和学习资源。希望本文能够为有此需求的读者提供一份实用的指南和参考。

- 上一篇: 揭秘:红娘子第二部震撼剧情全览

- 下一篇: 掌握网络营销制胜秘诀,轻松提升业绩!

-

如何注册MSN.com账户资讯攻略02-10

如何注册MSN.com账户资讯攻略02-10 -

如何轻松注册MSN.com账号资讯攻略11-16

如何轻松注册MSN.com账号资讯攻略11-16 -

轻松掌握!如何快速注册126邮箱资讯攻略01-10

轻松掌握!如何快速注册126邮箱资讯攻略01-10 -

轻松指南:怎样通过QQ号快速激活你的腾讯微博账户资讯攻略11-11

轻松指南:怎样通过QQ号快速激活你的腾讯微博账户资讯攻略11-11 -

如何快速激活财付通图标指南资讯攻略12-05

如何快速激活财付通图标指南资讯攻略12-05 -

火球网理财平台:轻松注册,快速购买指南资讯攻略01-19

火球网理财平台:轻松注册,快速购买指南资讯攻略01-19